如何在你的服务器上本地部署ChatGPT:步骤详解

如何在你的服务器上本地部署ChatGPT:步骤详解

你有没有想过,让ChatGPT在自己的服务器上运行?今天我们就来聊聊这个话题,教你如何在服务器上本地部署ChatGPT。无论是ChatGPT 3.5,还是ChatGPT 4,我们都会一步一步带你完成。

为什么要本地部署ChatGPT?

首先,为什么我们要本地部署ChatGPT呢?这里有几个原因:

- 隐私保护:所有数据都在你自己的服务器上,确保不会泄露。

- 定制化:你可以根据自己的需求修改和优化。

- 成本控制:避免了使用第三方服务的持续费用。

本篇文章将涵盖从开始到完成部署的每个步骤,确保你能顺利完成ChatGPT的本地化部署。

步骤一:准备工作

在开始之前,我们需要准备一些必要的工具和环境。

- 一台性能较好的服务器,推荐至少16GB内存。

- 安装Python(版本3.8以上)。

- 安装Docker,用于容器化部署。

这些工具可以帮助我们更快地完成ChatGPT的部署。

步骤二:下载模型文件

接下来,我们需要下载ChatGPT的模型文件。你可以从开放的模型库(如Hugging Face)或OpenAI的页面下载。

- 访问模型库页面,下载ChatGPT模型文件。

- 将文件解压到服务器的指定目录。

步骤三:配置环境

现在我们需要配置服务器的环境。

首先,确保已安装必要的依赖库。你可以通过以下命令轻松完成:

pip install -r requirements.txt然后,我们需要加载ChatGPT模型:

import openai

openai.api_key = 'your-api-key'

model = openai.ChatCompletion.create(

model="your-model-name",

prompt="你好,ChatGPT!",

max_tokens=150

)

步骤四:启动服务

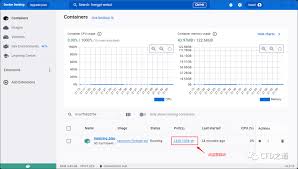

接着,我们来启动ChatGPT服务。这一步我们可以使用Docker来简化流程。

- 编写Dockerfile文件,配置服务启动脚本。

- 运行以下命令,构建Docker镜像并启动容器:

docker build -t chatgpt-local . docker run -d -p 5000:5000 chatgpt-local

步骤五:测试和部署

服务器启动后,我们需要对服务进行测试,确保它能正常工作。你可以通过发送一个测试请求来验证:

curl -X POST http://localhost:5000/api/chat -d '{"prompt": "你好,ChatGPT!"}'如果返回了正确的响应,恭喜你,你的ChatGPT已经成功本地化部署完成了!

实用建议

在日常使用中,这些小技巧可以帮助你更好地管理和优化ChatGPT服务:

- 定期更新模型文件,确保获得最新的功能和优化。

- 监控服务器性能,保证ChatGPT的响应速度。

- 设置适当的访问控制,保护你的服务不被滥用。

常见问题解答

这里是一些常见问题和解答,帮助你解决可能遇到的问题:

- Q: 为什么我的服务无法启动?

A: 检查环境配置是否正确,并确认所有依赖库都已安装。

- Q: 模型文件的下载速度很慢怎么办?

A: 尝试使用镜像站点下载,或者使用加速工具。

- Q: 如何优化ChatGPT的响应时间?

A: 增加服务器性能,使用缓存技术减小延迟。

总结与行动建议

在这篇文章中,我们详细介绍了如何在服务器上本地部署ChatGPT。从准备工作到完成部署,每一步都有详实的说明。现在你已经掌握了这些步骤,赶紧动手试试吧!

部署ChatGPT不仅提高了数据安全性,还能根据你的需要进行定制。如果在实际操作中遇到任何问题,欢迎在评论区提问,我们将尽力为你解答。