详细指南:如何在本地部署gpt-sovits、chatgpt、fastgpt、autogpt和db-gpt

详细指南:如何在本地部署gpt-sovits、chatgpt、fastgpt、autogpt和db-gpt

大家好!今天我们将和大家一起探索一种非常有用的工具,那就是GPT模型。通过这篇文章,你将学习如何在本地部署gpt-sovits、chatgpt、fastgpt、autogpt和db-gpt。本地部署这些模型不仅可以带来更多的自由,也能更好地保护你的隐私。

为什么本地部署GPT模型很重要?

随着AI技术的快速发展,许多优秀的GPT模型已经被广泛应用。但是,如果你想完全掌握这些工具,最好的方法就是在本地进行部署。本地部署不仅可以节约成本,提高响应速度,还可以更好地掌握数据隐私。

在本篇文章中,我们会详细介绍如何一步步在你自己的电脑上部署gpt-sovits、chatgpt、fastgpt、autogpt和db-gpt,让你能够充分利用这些强大的工具。

直接开启我们的GPT 本地部署之旅吧!

如何在本地部署GPT-Sovits

1. 环境准备

首先,你需要确保你的电脑符合下面的最低系统要求:

- 操作系统:Windows 10/11 或者 Linux

- 显卡:支持CUDA的NVIDIA显卡

- CUDA Toolkit和CUDNN已安装

2. 下载和安装

接下来,我们需要从GitHub下载GPT-Sovits项目:

- 打开

https://github.com/RVC-Boss/GPT-SoVITS - 下载项目代码并解压到本地目录

- 运行安装脚本,安装所需的依赖库

3. 配置和运行

- 打开一个命令行终端,进入项目目录

- 运行配置脚本:

python config.py - 启动服务:

python run.py

经过这些步骤,你应该能够在本地成功运行GPT-Sovits。

本地部署ChatGPT的详细步骤

1. 环境准备

与GPT-Sovits类似,我们需要先确保环境达标。这次除了CUDA Toolkit,还需要安装Python和一些相关的Python库。

准备工作包括:

- 安装Python:

https://www.python.org/ - 安装Python库:

pip install transformers

2. 下载和安装ChatGPT模型

- 访问OpenAI官方网站:

https://openai.com,并在此下载库文件 - 安装模型:

pip install openai

3. 配置和运行

下载和安装好库文件后,接下来你可以编写一个简单的Python脚本来启动ChatGPT。

- 创建一个新的Python文件,例如chatgpt_app.py

- 在文件中加入代码来调用ChatGPT:

import openai

openai.api_key = "<你的API密钥>"

response = openai.ChatCompletion.create(model="gpt-3.5-turbo", messages=[{"role": "user", "content": "你好"}])

print(response)

运行这个脚本,你就可以在本地与ChatGPT进行交互了。

快速部署FastGPT的一些技巧

1. 环境准备

我们需要准备好基础的Python环境和一些依赖库,同样需要NVIDIA显卡和CUDA支持。

- 安装Python:

https://www.python.org/ - 安装相应依赖库:

pip install fastai

2. 下载和安装FastGPT模型

从GitHub或其他资源上下载FastGPT的模型文件,并进行安装:

- 访问相关资源仓库

- 下载FastGPT的相关模型和代码

- 按照文档中的步骤完成安装

3. 在本地运行模型

安装完成后,可以通过以下方式在本地运行:

- 进入项目目录

- 运行初始化脚本:

python setup.py - 启动服务:

python run.py

进行AutoGPT和DB-GPT的本地部署

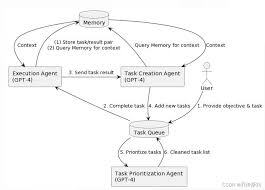

AutoGPT 部署步骤

AutoGPT在贴近用户操作的同时,也支持自动化任务。这些步骤可以帮助你快速部署:

- 同样需要NVIDIA显卡、Python环境、CUDA支持。

- 下载AutoGPT的库文件并安装。

- 配置好API密钥和初始参数。

DB-GPT 部署步骤

DB-GPT是一款功能全面的大数据模型,它适用于多种数据库操作。部署步骤如下:

- 预备Python和CUDA支持的环境。

- 下载DB-GPT库文件。

- 根据需求进行配置,启动本地服务。

实用建议和小技巧

使用强大的硬件设备

为了确保模型运行的流畅性,强烈建议使用较高配置的硬件设备。

定期更新

定期检查并更新库文件,可以确保模型的最新功能和安全性。

学习基础编程知识

掌握一些Python编程基础,可以帮助你在遇到配置问题时更容易解决。

依赖库管理

使用虚拟环境进行依赖库管理,避免不同项目间的依赖冲突。

加入讨论社区

加入相关的用户讨论社区,可以帮助你快速找到问题的解决方案。

常见问题解答

1. 部署过程中遇到内存不足怎么办?

答:如果你遇到内存不足的问题,可以尝试减少模型的批处理大小或者升级你的硬件设备。

2. Nvidia显卡不支持CUDA怎么办?

答:你可以考虑更换一块支持CUDA的NVIDIA显卡,或者选择一些不需要CUDA支持的模型。

3. API密钥泄露了怎么办?

答:及时生成一个新的API密钥,并更新到你的项目配置文件中。

4. 如何提升模型的运行速度?

答:你可以考虑升级硬件设备,扩展内存和使用SSD来替代传统硬盘。

5. 如何参与社区并贡献代码?

答:你可以访问对应项目的GitHub页面,查看贡献指南,并提交你的代码贡献。

总结与行动建议

通过本地部署GPT模型,你可以更好地掌握这些强大的AI工具。从安装环境、下载和安装到配置和运行,每一步都至关重要。记住,选择适合你硬件环境的模型,并定期更新和维护。

现在就去尝试吧!开始初步的部署,并逐步深入掌握这些工具。相信通过不断的练习,你一定能够在本地顺利运行gpt-sovits、chatgpt、fastgpt、autogpt和db-gpt。