如何应对OpenAI请求过多的错误信息:降低请求频率的策略

如何应对OpenAI请求过多的错误信息:降低请求频率的策略

你是不是在使用OpenAI的API时遇到了“you’re making too many requests please slow down”这个烦人的错误信息?别担心,这篇指南会手把手教你如何解决这个问题。让我们一起来探讨如何降低请求频率,调整请求策略,确保你的使用体验不受影响。

为什么会出现“you’re making too many requests please slow down”错误

该错误信息通常是因为你在短时间内向OpenAI发送了过多的请求,超过了他们的速率限制。速率限制是为了防止服务器被过多请求淹没,确保所有用户都能获得良好的服务。

如何降低请求频率

1. 分散请求时间

最简单的方法就是减少并分散你的请求频率。可以通过在每个请求之间添加一些延迟来实现。例如,你可以在每次请求之间等3-5秒。

2. 实现指数退避策略

当你遇到速率限制错误时,尝试使用指数退避策略。这意味着每次在遇到错误后,等待的时间会逐步增加,然后再重试。例如,第一次等待1秒,第二次等待2秒,依此类推。

3. 使用缓存机制

如果你的请求涉及大量相同的数据,可以使用缓存来减少请求频率。例如,当你第一次获取数据时将其保存,并在稍后直接使用缓存的数据,而不是向服务器发送新的请求。

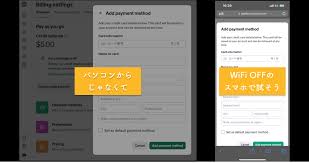

4. 请求增加速率限制

联系OpenAI并请求增加你的速率限制,这样你可以在短时间内发送更多请求。这通常适用于企业用户或有特殊需求的开发者。

常见问题解答

问:速率限制具体是多少?

答:速率限制取决于你使用的API类型和账户等级。你可以在OpenAI的账户设置中查看具体的限制。

问:为什么我一开始就遇到这个错误?

答:可能是由于你的代码或脚本在短时间内发送了大量请求。检查你的代码,确保每个请求之间有足够的间隔。

问:能不能一次性提交大批量数据?

答:最好不要一次性提交过多数据,而是分批提交,减少网络的压力。具体如何分批提交可以根据实际情况调整。

总结

简而言之,遇到“you’re making too many requests please slow down”错误的时候,别慌!你可以通过分散请求时间、使用指数退避策略、利用缓存机制以及请求增加速率限制来解决问题。希望这些方法能帮助到你,让你在使用OpenAI时更加顺畅。

现在就尝试这些方法吧,看看能否改善你的使用体验。如果你有任何新的发现或者更好的方法,欢迎留言分享!😄